Un robot con visión activa

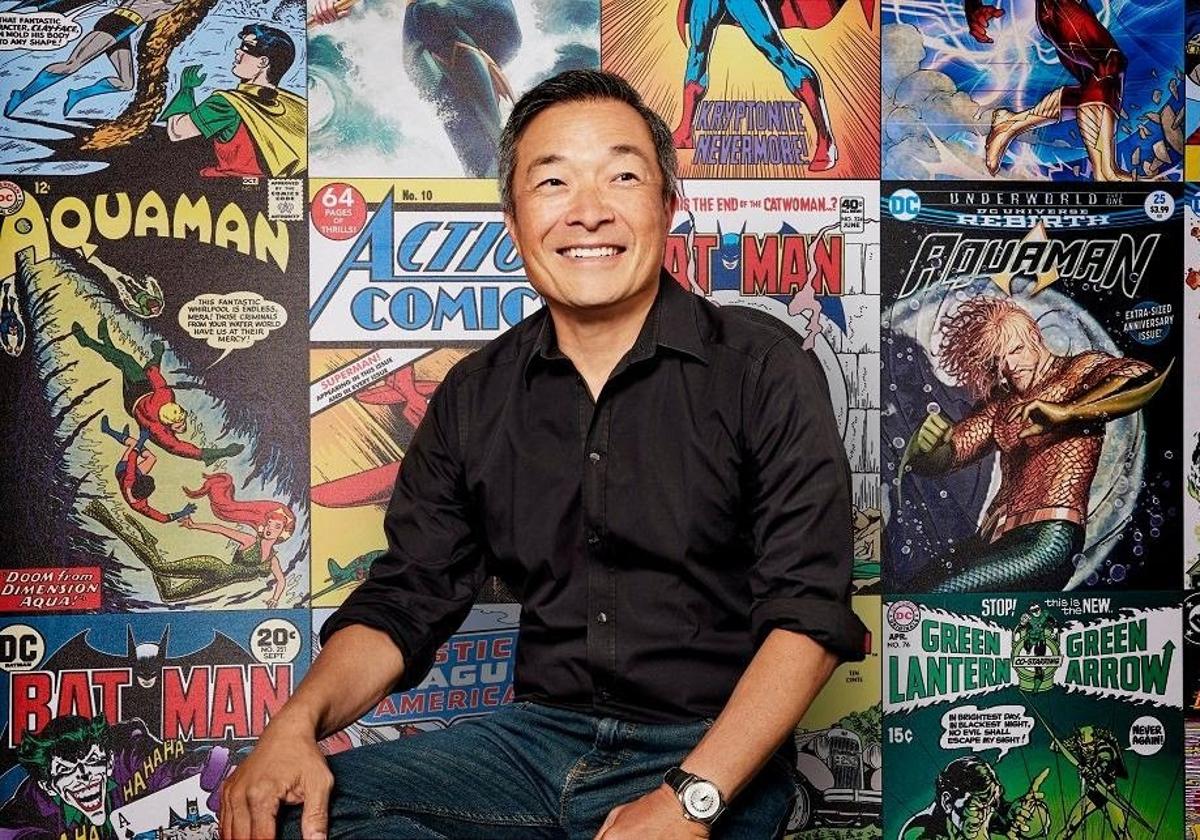

El proyecto pretende desarrollar un androide social que sea capaz de interactuar con personas Investigadores de la UMA desarrollan un software para el reconocimiento de gestos

LAURA P. TORRES

Lunes, 30 de noviembre 2009, 10:20

Una de las parejas más entrañable de la ciencia ficción, pertenecientes a la saga 'Star Wars', son C3PO, el hombrecito dorado, un androide de protocolo programado para el trato con todo tipo de seres galácticos, y R2D2, que conduce y repara naves espaciales. Ambos son robot sociales, y la convivencia con máquinas similares en nuestra sociedad aún pertenece a un futuro, pero cada vez más cercano.

Un grupo de Ingeniería de Sistemas Integrados (ISIS) del Departamento de Tecnología Electrónica de la Universidad de Málaga (UMA), dirigido por el doctor Antonio Jesús Bandera Rubio, trabaja en el desarrollo de un software que imita la capacidad de la retina del ser humano y capta gestos para mejorar la interacción de un robot con personas.

«Hemos trabajado con cámaras y sensores para reconocer objetos, obtener características relevantes o detectar caras», comenta Bandera Rubio, quien añade que «después de elaborar la estructura del androide con las ruedas y los motores, esta visión por sensores nos permite que la plataforma navegue evitando obstáculos, haciendo un mapa del entorno e identificándolo».

Robótica de servicios

Asimismo, «queríamos que el sistema de visión nos ayudara a que el robot detectara que hay una persona que lo está mirando, que se le está acercando, que le hace un gesto determinado, fácilmente reconocible como un «hola», y que se dé cuenta de que quieren interactuar con él y qué información le están dando».

«La aplicación final del sistema será en el campo de la robótica de servicios», según el investigador. Así, la Federación Internacional de Robótica (IFR) define a este tipo de robot como aquel que opera de forma parcial o totalmente autónoma para realizar acciones útiles destinadas al bienestar de las personas y del equipamiento, excluyendo operaciones de manufactura. En este apartado se sitúan, por ejemplo, los robots que se utilizan en cirugías poco invasivas.

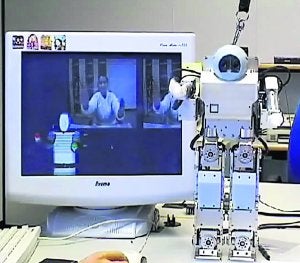

Ahora, «estamos en el nivel más bajo del proyecto, en la cual el androide ve cosas, las identifica, percibe, procesa y da más información», dice el profesor, quien aclara, como ejemplo, que «una cosa es medir la temperatura de una habitación y otra es decir que hace frío. Esa es la diferencia entre identificar y percibir».

Actualmente, este grupo de investigadores de la UMA desarrolla un sistema de visión con cámaras, lo que le permite obtener la profundidad de las cosas y controlar las distancias. De esta forma, «el robot es capaz de coger objetos», dice Bandera Rubio, que especifica que «con el sistema estéreo, con dos cámaras, trabajamos en la parte del software que desarrolla el mecanismo de atención, facultad que permite sacar de una imagen los detalles más interesantes y desechar los que no interesan».

En esta línea, el científico explica que existen estudios de Psicología que enseñan imágenes y graban cómo se mueven los ojos de las personas, y a qué elementos enfocan primero. Por ejemplo, en una cara la atención va hacia los ojos, y después hacia la boca. «Nosotros trabajamos en la implementación de estos estudios y elaboramos un sistema de atención que permite trabajar la imagen, y que se denomina visión activa», subraya Bandera Rubio, que hace hincapié en que «el cerebro participa en la acción de mirar, y no es un proceso pasivo. A los ojos no les entra toda la información y el cerebro luego selecciona, sino que es el cerebro el que determina a qué zonas enfocar e imparte la orden».

El responsable del proyecto resume que éste consta de tres partes, «la visión activa, y otros dos campos de estudio más avanzados como es la interacción, que encabeza el también profesor de la UMA, Juan Pedro Bandera Rubio, y la navegación por sensores».

Aprendizaje y comprensión

En cuanto a la interacción, el robot identifica y hace un seguimiento de forma automática del movimiento que una persona le hace. «Intentamos enseñarle y desarrollar su capacidad de aprendizaje», añade. «De esta manera, el androide nos imita y pasa a sus articulaciones lo que nosotros le hacemos», comenta el doctor, que insiste en que «el cuerpo del humanoide no es como el de una persona y hace gestos parecidos, nunca iguales. Queremos que sea capaz de almacenar acciones en una librería y que mejore su capacidad de reconocimiento fijándose en puntos concretos como manos o codos», dice.

Comentar es una ventaja exclusiva para suscriptores

¿Ya eres suscriptor?

Inicia sesiónNecesitas ser suscriptor para poder votar.